Robots.txt क्या है? क्या आपने कभी इसके बारे में सुना है, यदि नहीं तो आज आपके लिए खुसखबरी की बात है क्यूंकि आज में आप लोगों को Robots.txt के बारे में कुछ जानकारी प्रदान करने वाला हूँ।

यदि आपका कोई Blog या फिर website है तो आप ये जरुर महसूस किया होगा की कभी कभी हम जो चीज़ नहीं चाहते हैं वो सारे information भी Internet में public हो जाते हैं, क्या आपको पता है की ऐसा क्यूँ होता है. क्यूँ हमारे बहुत सारे अच्छे contents भी बहुत दिनों बाद index नहीं हुए होते. यदि इन सभी चीज़ों के पीछे की रहस्य के बारे में जानना है तो आपको ये article Robots.txt क्या है पुरे ध्यान से पढना होगा जिससे आपको article के end तक इन सभी चीज़ों के बारे में पता चल जायेगा।

Search Engines को ये बताना की कोन से Files और Folders को website में सारे public को दिखाना है और किन चीज़ों को नहीं इसके लिए Robots metatag का इस्तमाल होता है. लेकिन सारे Search Engines को Metataga को पढना नहीं आता, इसलिए बहुत से Robots Metatag बिना पढ़े गए ही unnoticed चले जाते हैं. इसके लिए जो बेहतरीन तरीका है वो है की Robots.txt File का इस्तमाल करना जिससे की बड़ी आसानी से Search Engines को अपने Website या Blog के Files और Folders के बारे में सुचना दी जा सकती है।

तो आज मैंने ये सोचा की क्यूँ न आप लोगों को Robots.txt क्या है के बारे में पूरी जानकारी दे दी जाये जिससे की आपको भी आगे इसे समझने में कोई तकलीफ न हो. तो फिर देरी किस बात की चलिए शुरू करते हैं और जानते हैं की आखिर ये Robots.txt क्या है और इसके क्या फायेदे है।

Robots.txt क्या है

Robots.txt एक text file होता है जिसे की आप अपने site में रखते हो ताकि आप Search Robots को ये बता सको की उन्हें आपके site में किन pages को visit करना है या crawl करना है और किन्हें नहीं।

वैसे Robots.txt को पालन करना search engines के लिए mandatory नहीं है लेकिन वो इसे जरुर ध्यान देते हैं और इसमें mentioned किये गए pages और folders को visit नहीं करते. उस हिसाब से Robots.txt बहुत ही महत्वपूर्ण है. इसलिए इसे main directory में रखना अत्यंत जरुरी है जिससे की search engine को इसे ढूंडने में आसानी होती है।

- SEO Friendly Blog Post कैसे लिखे जो आसानी से Rank करे

- Google AMP क्या है

- Bounce Rate क्या है और इसे कैसे कम करे

यहाँ ध्यान देने वाली बात यह है की अगर हम इस file का सही जगह में implementation न करें तो Search Engines को ये लगेगा की शायद आपने robot.txt file को include ही नहीं किया है जिससे की आपके site के pages शायद index भी न हों।

इसलिए इस छोटे से file की बहुत ज्यादा importance है यदि इसका इस्तमाल ठीक से नहीं किया गया तब इससे आपके website की ranking भी कम सकती है. इसलिए इसके बारे में अच्छी जानकारी होना बहुत ही जरुरी है.

ये कैसे काम करता है?

कोई भी search engines या Web Spiders यदि आपके website या blog को पहली बार आये हैं तो वो पहले आपके robot.txt file को crawl करते हैं क्यूंकि इसमें आपके website को लेकर सारी जानकारी होती है की किन चीज़ों को crawl नहीं करना है और किन्हें करना है. और वो आपके निर्देशित pages को index कर देती हैं, जिससे की आपके indexed pages search engine results में प्रदर्शित होते हैं।

Robots.txt files आपके लिए बहुत फायेदेमंद साबित हो सकते हैं यदि :

कैसे robots.txt file को बनाया जाता है

यदि आपने अभी तक भी अपने website या blog में robots.txt file बनाया नहीं है तब आपको खूब शीघ्र ही इसे बना लेना चाहिए क्यूंकि ये आगे चलकर आपके लिए काफी फायेदेमंद साबित होने वाला है. इसे बनाने के लिए आपको कुछ निर्देशों को पालन करना होगा :

- सबसे पहले एक text file बनायें और उसे robots.txt के नाम से save करें. इसके लिए आप NotePad का इस्तमाल कर सकते हैं यदि आप Windows का इस्तमाल करते हैं तब या TextEdit का यदि आप Macs का इस्तमाल करते हैं और उसके बाद उसे text-delimited file के हिसाब से save कीजिये.

- उसे अब अपने website के root directory में upload कर लीजिये. जो की एक root level folder होता है और उसे “htdocs” भी कहा जाता है और वो आपके domain name के बाद appear होता है.

- अगर आप subdomains का इस्तमाल करते हैं तब आपको सभी subdomain के लिए अलग अलग robots.txt file बनाने की जरुरत है.

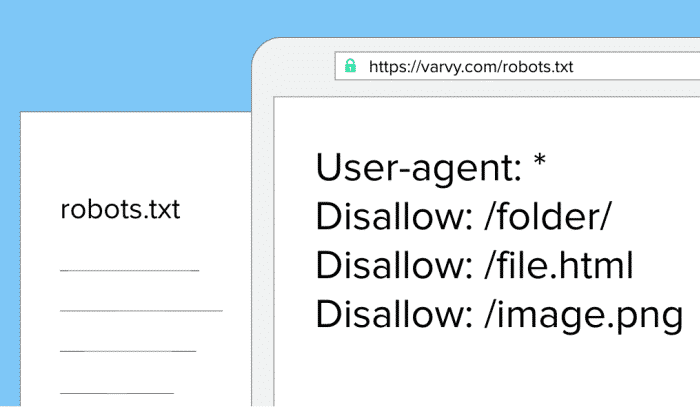

Robots.txt की Syntax क्या है

Robots.txt में हम कुछ syntax का इस्तमाल करते हैं जिनके बारे में हमें जानना बहुत ही जरुरी है।

• User-Agent: वो robot जो की ये सारी rule को follow करते हैं और जिनमें ये applicable हैं (e.g. “Googlebot,” etc.)

• Disallow: इसका इस्तमाल करने का मतलब है की वो pages को bots से block करना जिन्हें आप नहीं चाहते हैं कोई दूसरा उसे access कर सके. (यहाँ प्रति files के पहले disallow लिखने की जरुरत है)

• Noindex: इसके इस्तमाल से search engine आपके उन pages को index नहीं करेगा जिन्हें की आप नहीं चाहते की वो indexed हो।

• सारे User-Agent/Disallow group को separate करने के लिए एक blank line का इस्तमाल करना चाहिए, लेकिन यहाँ ध्यान दें की दो groups के बिच कोई भी blank line न हो (User-agent line और the last Disallow के बिच gap नहीं होना चाहिए ।

• Hash symbol (#) का इस्तमाल comments देने के लिए किया जा सकता है within a robots.txt file, जहाँ की सभी चीज़ें जिसके पहले # की symbol होगी उन्हें ignore कर दिया जायेगा. इन्हें मुख्य रूप से whole lines or end of lines के लिए इस्तमाल किया जाता है।

• Directories और filenames case-sensitive होते हैं : “private”, “Private”, and “PRIVATE” ये सारे search engines के लिए एकदम अलग अलग हैं.

चलिए के उदहारण के मदद से इसे समझते हैं. यहाँ निचे मेंने उसके बारे में लिखा है।

• यहाँ जो robot “Googlebot” है उसमें कोई भी disallowed की statement नहीं लिखी गयी है जिससे की ये free है कहीं भी जाने के लिए

• यहाँ सारे site को बंद कर दिया गया है जहाँ की “msnbot” का इस्तमाल हुआ है

• सारे robots (other than Googlebot) को /tmp/ directory or directories or files called /logs को देखने की permission नहीं है, जिन्हें की निचे explain किया गया है comments के माध्यम से e.g., tmp.htm,

/logs or logs.php.

User-agent: Googlebot

Disallow:

User-agent: msnbot

Disallow: /

# Block all robots from tmp and logs directories

User-agent: *

Disallow: /tmp/

Disallow: /logs # for directories and files called logs

Advantages of using Robots.txt

वैसे देखा जाये तो robots.txt के इस्तमाल करने के बहुत से फा ये दे है लेकिन मैंने यहाँ कुछ बहुत ही महत्वपूर्ण फा ये दे के बारे में बता या है जिनके बारे में सभी को जानकारी होना चाहिए।

- robots.txt के इस्तमाल से आपके sensitive information को private रखा जा सकता है.

- Robots.txt के मदद से “canonicalization” problems को दूर रखा जा सकता है or multiple “canonical” URLs को भी रखा जा सकता है. इस problem को भूल वसतः “duplicate content” problem भी कहा जाता है .

- इससे आप Google Bots की मदद भी कर सकते हैं Pages को index करने के लिए.

क्या होगा अगर हम robots.txt file का इस्तमाल न करें तब?

यदि हम कोई भी robots.txt file का इस्तमाल नहीं करते तब seach engines पर कोई पाबन्दी नहीं होती की कहाँ crawl करना है और कहाँ नहीं इससे वो सभी चीज़ों की index कर सकते हैं जो भी उन्हें आपके website में मिले।

ये बहुत से websites के लिए सभी भी है लेकिन यदि हम कुछ अच्छे practice की बात करें तब हमें robots.txt file का इस्तमाल करना चाहिए क्यूंकि इससे search engines को आपके pages को index करने में आसानी होती हैं, और उन्हें सारे pages को बार बार जाने की जरूरत नहीं पड़ती।

आज आपने क्या सीखा

मुझे पूर्ण आशा है की मैंने आप लोगों को Robots.txt क्या है के बारे में पूरी जानकारी दी और मैं आशा करता हूँ आप लोगों को Robots.txt के बारे में समझ आ गया होगा. मेरा आप सभी पाठकों से गुजारिस है की आप लोग भी इस जानकारी को अपने आस-पड़ोस, रिश्तेदारों, अपने मित्रों में Share करें, जिससे की हमारे बिच जागरूकता होगी और इससे सबको बहुत लाभ होगा. मुझे आप लोगों की सहयोग की आवश्यकता है जिससे मैं और भी नयी जानकारी आप लोगों तक पहुंचा सकूँ।

मेरा हमेशा से यही कोशिश रहा है की मैं हमेशा अपने readers या पाठकों का हर तरफ से हेल्प करूँ, यदि आप लोगों को किसी भी तरह की कोई भी doubt है तो आप मुझे बेझिजक पूछ सकते हैं. मैं जरुर उन Doubts का हल निकलने की कोशिश करूँगा।

आपको यह लेख Robots.txt क्या है कैसा लगा हमें comment लिखकर जरूर बताएं ताकि हमें भी आपके विचारों से कुछ सीखने और कुछ सुधारने का मोका मिले।

Thanks sir ।

मेरे wordpress blog के 162 page index थे अब वह घटकर 156 हो गए और रोज घटते ही जा रहे हैं , क्या कारण हैं please बताने की कृपा करें। कम से कम इतना बता dijye की De indexing का क्या कारण हैं ।

Apke content quality ke karan.

Alternate page with proper canonical tag error aa raha kaise sovle kru help

भाई मेरे ब्लॉग के शेयर किए हुए ब्लॉग पोस्ट की urls Google में index हो रहे है, और उसके वजह से blocked by robots.txt का इश्यू आ रहा है। मै क्या करू ? प्लीज मेरी सहायता कीजिए?

अगर कोई व्यक्ति मेरे ब्लॉग के आर्टिकल को किसी social media साइट पर शेयर करता है, तो वह url Google का बोट इंडेक्स कर लेता है। तो इसे कैसे रोके???

This blog is very informative. thanks for sharing. acharya mukti ji and team comes under india’s best astrologers.

Very help full post sir thanka

Thanks this information

Thanx for sharing this article about robots.txt

Very good article. Thank you.

User-agent: *

Allow: /

Sitemap: https://www.rishabhhelpme.com/sitemap.xml

sir mere blog ka robots. file esa hai kya ye shi hai please bataye.

Han, ye sahui hai.

bhai mujhe k hlp chaiye … mere blog ki language bhi apki blog ki tarah hai … mujhe Hreflang tag use karna hai .. mujhe hreflang coding chaiye ..

Helpful information given. Newbees Beginners ke liye agar aap robots.txt ka ek example set karke step by step bata de to aur achche se samajh aa jayega. Mujhe koi post noindex karni hai to kaise karu kuch samajh nahi aa raha. Plz guide..

Hi Sir अभी कुछ दिन पहले मैंने अपने एक वेबसाइट का seo किया और गूगल वेबमास्टर में submit भी किया पता नही क्यों मेरा वेबसाइट गूगल पर अपने डोमेन नाम और यूआरएल टाइप करके search करने पर भी वेबसाइट का यूआरएल भी गूगल पर दिख नही रहा है .

कुछ robots.txt करके error दिखा रहा है गूगल वेबमास्टर में मै इस प्रॉब्लम को कैसे solve करू sir प्लीज हेल्प me…

Par apka site to dikha raha hai.

Thik se check kariye.

muje apki help chahiye. mera robots txt me user agent blank show ho raha hey…aur mera post bhi index nehi ho raha hey…please is bare mey help kijeye

esa dika raha hey mera robots txt.

>

user- agent:

Isme koi problem nahi hai.

Thanks for this post-

what’s the difference between ‘Disallow:’ and ‘Disallow: /’ ?

Very useful

very good artical

hello sir

apkeka artical pad kar acha laga , on kuch congfusion bhee duur hua or padney or samjhney mai bhee saral laga , ye bhaul he chaaa pryass hai sir backlink kai uppar bhee koi artical laaye

Useful info shared. Nice work

very good content

Thanks

very nice and useful content. thanks

Thanks

hello sir isse me apni blogger website me kaise add aur use kar sakta hun

Apko blogger ke settings me mil jayega.

Schema or Rich Snippet me kya difference hain ?

Thanks

I learn much as possible about robots.txt but I want to see the implementation of robots.txt in the visual form please you can provide this

. It can be image form or video form

Hi नमस्कार sir मेरा एक प्रश्न है मै ये जानना चाहता हु की Black hat SEO क्या होता है और कैसे करते है ,क्या black hat seo के द्वारा अपनी website को google के first page पे कितने दिनों में लाया जा सकता है.sir black hat seo करना चाहिए की नही क्या black hat seo के द्वारा हम किसी website को google के search engine में टॉप पे ला सकते है

Iska article apko seo category me mil jayega

1 month only black hat seo se ap ki site aati h but fir google se 15 days m chali b jayegi fir kbhi nhi ayegi

😀 this Post Is amezing unfortutently I cannot undersrand Pure Hindi coz i can understand only Hinglish, :v i would like to know is this blog Hinglish or Hindi in life time?

Hello Satpal, Our Blog is a Hindi Technology blog and it will remain as it is for lifetime. Sorry to hear that you are not able to understand some instances. However you can ask your doubts at https://ask.hindime.net/ if you have any.

very Good Article and useful,thank for given information about robot.txt

Thanks Sagar.

Beginners के लिए बहुत उपयोगी जानकारी है, धन्यवाद

Thanks. अधिक जानकारी के लिए आप हमें हमारे Community में अपने सवाल पूछ सकते हैं https://ask.hindime.net/

जहाँ आपको आपके सारे सवालों के जवाब बहुत ही जल्द मिल जाएगी.

very nice so nice

Very Useful article.

Very nice